Explorez les principaux risques éthiques posés par l'IA. Découvrez des exemples concrets et apprenez comment relever ces défis dans un paysage juridique en constante évolution.

Introduction

Dans l'article précédent, Deep Lex a exploré la manière dont l'évolution rapide de l'IA soulève des questions éthiques fondamentales liées au développement et à l'utilisation de l'IA.1- des questions que les juridictions du monde entier s'efforcent de traiter par l'introduction de nouvelles lois et politiques. Nous avons discuté de la manière dont l'éthique façonne le cadre de la gouvernance de l'IA à l'échelle mondiale et examiné les approches divergentes de la réglementation de l'IA par l'UE, les États-Unis et la Chine, avec des implications clés pour les professionnels du droit.

Cet article va plus loin et présente la myriade de questions éthiques liées au développement de l'IA, en fournissant une feuille de route pour la prochaine série sur l'éthique de Deep Lex. Nous aborderons des questions essentielles telles que les préjugés et la discrimination, la responsabilité et la transparence, et nous explorerons l'impact de la résolution de ces problèmes.

Alors que nous approfondissons les implications de l'éthique de l'IA, il devient clair que la compréhension de ces principes est vitale pour les professionnels du droit qui sont à l'avant-garde de ce paysage en évolution rapide.

Pourquoi l'éthique de l'IA est-elle importante pour les professionnels du droit ?

L'éthique de l'IA n'est plus une préoccupation théorique mais une priorité pratique. Comprendre l'éthique de l'IA est donc essentiel pour les professionnels du droit, tant sur le plan conceptuel que pratique, car elle a des implications concrètes sur le risque client, la conformité réglementaire et les normes professionnelles. De la prise de décision automatisée dans la justice pénale à l'embauche pilotée par l'IA, les défis éthiques ont un impact direct sur les clients et les communautés. La prise en compte de risques tels que la partialité algorithmique et la confidentialité des données peut renforcer la confiance des clients et façonner les résultats juridiques, soulignant le rôle essentiel de la profession juridique dans la gouvernance responsable de l'IA. À l'inverse, les faux pas dans la gouvernance de l'IA peuvent exposer les clients à la responsabilité, mettre en péril la confidentialité des données et éroder la confiance du public - des résultats qui ont un impact sur les relations avec les clients et l'intégrité de la profession juridique.

Réglementation récente telle que la loi sur l'IA de l'UE2 (voir notre Global AI Regulatory Tracker pour plus d'informations) fixe des normes éthiques élevées à travers l'Europe qui affectent de nombreux secteurs, y compris la profession juridique. Ces normes exigent que les systèmes d'IA soient transparents, équitables et responsables,3 et soulignent l'importance des professionnels du droit dans l'interprétation et l'application de ces règles.

Les professionnels du droit doivent réfléchir à la manière dont les biais des modèles d'IA pourraient affecter des domaines tels que l'embauche, les évaluations de crédit ou les condamnations pénales. Il est essentiel de reconnaître ces implications pour guider les clients dans l'adoption de l'IA de manière responsable, tout en abordant de manière proactive les violations potentielles de l'éthique. Le déploiement de l'IA dans la justice pénale4 et les processus d'embauche5 illustre l'impact direct de ces défis sur les clients et les communautés.

Ces préoccupations éthiques touchent à des questions fondamentales telles que les droits de l'homme, la justice sociale et l'avenir du travail. Pour une perspective plus large de l'impact sociétal de l'IA, voir le récent essai stimulant de Dario Amodei, PDG d'Anthropic, publié dans Octobre 2024, qui explore le potentiel de l'IA à façonner la société, pour le meilleur et pour le pire. Ces questions sont particulièrement cruciales dans des domaines tels que le droit, les soins de santé et l'administration, où les décisions prises par l'IA peuvent avoir des répercussions profondes sur les individus et les communautés.

En plus de conseiller leurs clients, les professionnels du droit ont un rôle à jouer dans les discussions sur les politiques d'IA. En participant à l'élaboration des politiques, en établissant les meilleures pratiques et en plaidant en faveur d'une surveillance globale, ils contribuent à orienter le développement éthique de l'IA dans le respect de l'intérêt public et des principes démocratiques. Pour les juristes d'aujourd'hui, l'éthique de l'IA n'est pas seulement un domaine de connaissance, mais une pierre angulaire d'une pratique responsable.

En gardant à l'esprit les responsabilités des professionnels du droit, nous devons maintenant examiner les principaux défis éthiques qui se posent lors de la mise en œuvre des systèmes d'IA dans différents secteurs.

Le paysage éthique de l'IA

La réglementation et la politique en matière d'IA reposent de plus en plus sur des principes éthiques fondamentaux, notamment les droits de l'homme, la justice, l'État de droit et la démocratie.

L'UE a démontré que l'intégration de principes éthiques fondamentaux - tels que les droits de l'homme, la justice, l'État de droit et la démocratie - dans le développement de l'IA est essentielle pour parvenir à une IA digne de confiance. L'UNESCO6 et l'OCDE7 ont également défendu ces principes dans leurs travaux sur l'éthique de l'IA, établissant des normes fondamentales qui continuent à guider d'autres juridictions dans leurs premiers pas vers une réglementation de l'IA.

Ces valeurs encadrent les défis éthiques complexes que l'IA pose aux sociétés, à la gouvernance et aux systèmes juridiques :

- Imputabilité et responsabilité

- Question clé : Il peut être complexe de déterminer les responsabilités lorsque les systèmes d'IA causent des dommages ou commettent des erreurs.

- Défi juridique : Élaborer des cadres pour la responsabilité de l'IA et adapter les lois existantes sur la responsabilité civile et la responsabilité du fait des produits aux contextes de l'IA.

- Vie privée et protection des données

- Question clé : Les systèmes d'IA nécessitent souvent de grandes quantités de données, ce qui soulève des inquiétudes quant à la collecte, au stockage et à l'utilisation des données.

- Défi juridique : Assurer la conformité de l'IA avec les réglementations sur la protection des données (par exemple, GDPR, CCPA) et traiter les questions de consentement et de propriété des données.

- Autonomie et contrôle humain

- Question clé : À mesure que les systèmes d'IA deviennent plus autonomes, des questions se posent quant au niveau approprié de surveillance et d'intervention humaine.

- Défi juridique : Définir des normes juridiques pour les exigences relatives à l'intervention humaine dans les applications critiques de l'IA.

- Droits de propriété intellectuelle

- Question clé : Les contenus générés par l'IA soulèvent des questions sur la paternité, la propriété et la brevetabilité.

- Défi juridique : Adapter les lois sur la propriété intellectuelle aux œuvres et inventions créées par l'IA.

- Emploi et droits du travail

- Question clé : L'impact de l'IA sur le marché du travail soulève des questions éthiques concernant le déplacement et l'évolution de la nature du travail.

- Défi juridique : trouver un équilibre entre le progrès technologique et la protection des travailleurs et aborder les questions liées à l'IA sur le lieu de travail.

- L'IA dans le système juridique

- Question clé : L'utilisation de l'IA dans les processus juridiques (par exemple, la police prédictive, l'évaluation des risques dans la détermination de la peine) soulève des questions éthiques sur l'équité et la régularité de la procédure.

- Défi juridique : Élaborer des lignes directrices pour l'utilisation appropriée de l'IA dans le système judiciaire et garantir des protections constitutionnelles.

- Sûreté et sécurité de l'IA

- Question clé : Il est essentiel de garantir la sûreté et la sécurité des systèmes d'IA, en particulier pour les applications à fort enjeu.

- Défi juridique : Élaborer des normes de sécurité et des cadres de responsabilité pour les systèmes d'IA, en particulier dans des secteurs critiques tels que les soins de santé et les transports.

Ces défis sont aggravés par la nature "boîte noire" des systèmes d'IA, qui obscurcit les processus de prise de décision.

Le défi de la "boîte noire

La question de la "boîte noire" est un problème central de l'IA. Ce terme fait référence à l'opacité de certains modèles d'IA complexes qui masquent la manière dont les systèmes prennent des décisions. Ce manque de transparence soulève des questions juridiques et éthiques cruciales lorsqu'on envisage l'utilisation croissante de l'IA dans des domaines sensibles tels que les soins de santé, la finance et la justice pénale, où des biais ou des erreurs non détectés dans les systèmes d'IA peuvent causer de graves préjudices.

Un autre problème découlant de cette opacité est le dilemme entre la transparence de la technologie et la protection des secrets commerciaux. En d'autres termes, comment répondre à l'impératif de transparence algorithmique tout en protégeant la propriété intellectuelle et les secrets commerciaux ? (Cette question sera abordée plus en détail dans un prochain numéro de la série sur l'éthique).

Alors que nous naviguons sur ce terrain complexe, notre objectif est de doter les professionnels du droit des connaissances et des outils nécessaires pour relever ces défis de manière efficace et éthique.

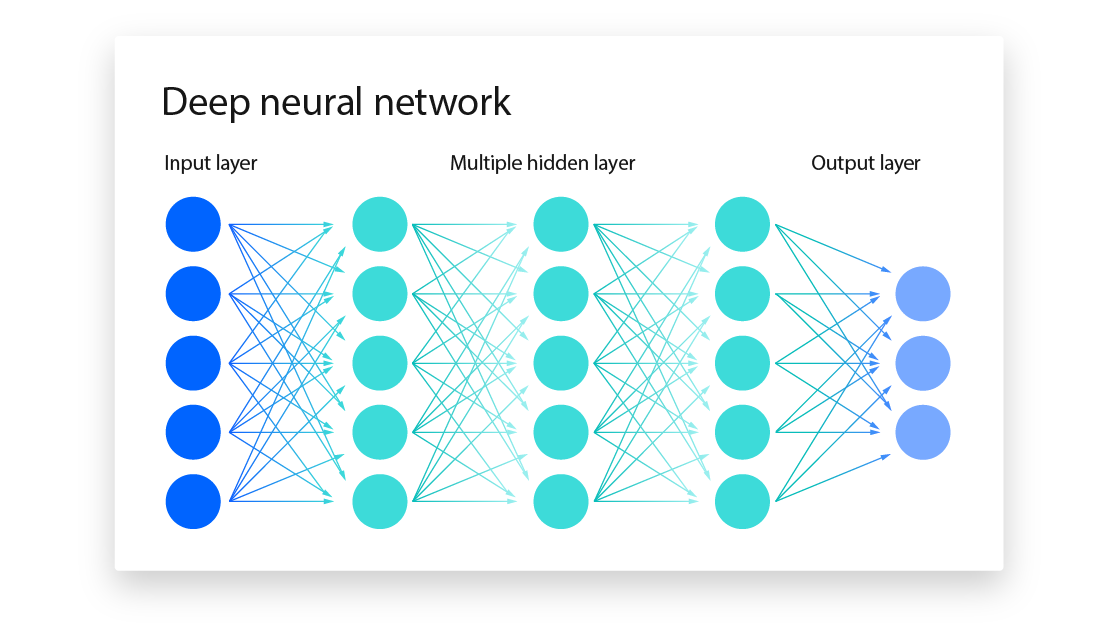

Brève explication de la nature "boîte noire" de l'IA

La nature de "boîte noire" des modèles complexes d'IA avec de multiples avocats neuronaux, comme l'apprentissage profond, est un défi critique pour la transparence et l'explicabilité. Ces termes se posent parce que les rouages internes sont souvent cachés ou trop complexes pour être clairement interprétés,8 et donc la manière dont ces systèmes obtiennent leurs résultats peut être opaque.

Ce problème est particulièrement prononcé dans les modèles comportant des milliards, voire des trillions de paramètres (comme le modèle GPT-4).9 Selon les critiques, de tels modèles rendent presque impossible de retracer le chemin de la décision. Ce manque d'interprétabilité soulève des questions éthiques et pratiques, en particulier dans des domaines sensibles tels que les soins de santé, la finance et la justice pénale.10

Du point de vue de l'industrie, des techniques d'IA explicable ("XAI") sont en cours d'élaboration pour atténuer ce problème. Par exemple, des méthodes telles que les Local Interpretable Model-agnostic Explanations ("LIME") et les SHapley Additive exPlanations ("SHAP") sont couramment utilisées pour déterminer approximativement comment les données influencent les résultats des modèles.11 LIME crée des modèles plus simples autour de prédictions spécifiques, tandis que SHAP utilise la théorie des jeux pour quantifier l'importance de chaque caractéristique dans une prédiction, ce qui permet d'obtenir des informations à la fois locales et globales sur le comportement du modèle. Ces techniques sont essentielles pour améliorer la transparence, bien qu'elles ne fournissent que des approximations des processus internes complexes des modèles d'apprentissage profond.12

Les universitaires ont identifié la question de la "boîte noire" comme un obstacle majeur à l'éthique de l'IA, car elle entrave les efforts visant à garantir l'équité, la responsabilité et la fiabilité.13 Les études soulignent que l'opacité de ces modèles restreint leur adaptabilité, limite la capacité à détecter les biais et complique l'identification des erreurs.14 Il est donc essentiel d'intégrer la capacité d'explication dans les systèmes d'IA si l'on veut qu'ils soient fiables dans les applications du monde réel.

La reconnaissance de ces défis ouvre la voie à une exploration critique des préjugés et de la discrimination dans l'IA, un domaine qui exige une attention et une action urgentes.

Biais et discrimination dans les systèmes d'IA

L'article suivant de la série Deep Lex Ethics débutera par une analyse des questions liées aux préjugés et à la discrimination dans l'IA, y compris la manière dont la réglementation nouvelle et évolutive peut traiter ces questions. En attendant, nous présentons ci-dessous une vue d'ensemble des questions à traiter.

Voici pourquoi cette question est si urgente :

Question 1 : Biais dans les données de formation et les algorithmes

- Les systèmes d'IA apprennent à partir de données, dont il a été démontré qu'elles reflètent les préjugés de la société.15 For example, if a hiring algorithm is trained on historical hiring data from a company with a history of gender or racial bias, the AI could end up perpetuating these biases by unfairly favouring certain candidates over others. 16

- Les décisions algorithmiques peuvent manquer de transparence, ce qui fait qu'il est difficile pour les individus de comprendre, et encore plus de contester, des résultats qui leur semblent injustes ou discriminatoires.

Question 2 : Impact sur les droits de l'homme et l'égalité

- L'IA utilisée pour la surveillance et la police prédictive,17 ou l'évaluation du crédit18 peut affecter de manière disproportionnée des communautés déjà vulnérables, renforçant ainsi les cycles de discrimination.

- Dans le domaine des soins de santé, les systèmes d'IA biaisés pourraient signifier que les minorités reçoivent des soins de moindre qualité en raison de diagnostics erronés ou de recommandations de traitement inadéquates.19

Thème 3 : Responsabilité et transparence

- Les modèles d'IA sont souvent complexes et difficiles à interpréter, ce qui pose des problèmes de responsabilité. Si un système d'IA prend une décision incorrecte ou biaisée, des questions essentielles se posent quant à la responsabilité des développeurs, des fournisseurs de données ou des utilisateurs de l'IA.

- En outre, le manque de transparence rend difficile la rectification des erreurs ou des préjudices, en particulier lorsque des personnes subissent un préjudice en raison d'une décision d'un système d'IA (voir ci-dessus le "défi de la boîte noire").

Question 4 : Échelle et rapidité du déploiement de l'IA

- Étant donné que l'IA peut être mise à l'échelle rapidement dans tous les secteurs, les systèmes biaisés ou injustes peuvent affecter un grand nombre de personnes avant que ces problèmes ne soient identifiés et résolus. Cela pourrait créer un préjudice important qu'il serait difficile d'inverser.

Question 5 : Autonomie et contrôle

- Lorsque les systèmes d'IA prennent des décisions avec peu de contrôle humain, les gens peuvent perdre leur autonomie sur des aspects clés de leur vie. Par exemple, les candidats à l'emploi peuvent être écartés par un algorithme sans que l'on comprenne pourquoi.20

- Ce problème affecte également les processus démocratiques, comme en témoignent les fausses informations alimentées par l'IA ou les publicités politiques microciblées dont il a été démontré qu'elles visaient à manipuler l'opinion publique et à influencer les élections.21 Ces exemples remettent en question l'autonomie individuelle au niveau sociétal.

Efforts et défis pour lutter contre les préjugés et garantir l'équité

Des efforts pour lutter contre les préjugés dans l'IA sont en cours dans les sphères universitaires, commerciales et réglementaires,22 mais le rythme de l'innovation technologique dépasse souvent le développement de garanties éthiques.

Les chercheurs et les développeurs se concentrent sur la création d'algorithmes plus équitables en utilisant des techniques telles que l'atténuation des biais, l'audit des modèles et l'apprentissage automatique tenant compte de l'équité.23 Ces techniques visent à identifier et à réduire les biais dans les données et les algorithmes. Par exemple, les entreprises expérimentent aujourd'hui des méthodes d'atténuation des biais dans les algorithmes d'embauche afin de s'assurer qu'elles ne discriminent pas les groupes sous-représentés.24

La coopération mondiale reste essentielle pour garantir que l'IA favorise le progrès plutôt que de perpétuer l'oppression. Les lignes directrices et les réglementations fondées sur l'éthique, comme la loi européenne sur l'IA, espèrent y parvenir en prônant l'équité, la responsabilité et la transparence. Toutefois, le véritable défi semble être que les réglementations et les cadres éthiques sous-jacents suivent le rythme de la technologie de l'IA à mesure qu'elle progresse.

Préparer un avenir éthique à l'IA

À mesure que l'IA transforme les secteurs de la société, l'importance de l'éthique de l'IA devient de plus en plus pressante, en particulier pour les professionnels du droit chargés de donner des conseils sur l'utilisation responsable et la conformité. Il est essentiel d'aborder les questions éthiques telles que les préjugés, la responsabilité et la transparence en matière d'IA pour protéger les droits individuels et veiller à ce que les technologies d'IA soutiennent le progrès social plutôt que de renforcer les inégalités. Les professionnels du droit jouent donc un rôle essentiel en guidant leurs clients à travers les réglementations relatives à l'IA et les exigences en matière de respect des cadres éthiques par l'IA.

Pour rester efficaces, les juristes doivent s'engager à suivre une formation continue en matière d'éthique de l'IA, en restant informés des derniers développements réglementaires et des meilleures pratiques émergentes. Un engagement proactif dans les discussions politiques permettra aux professionnels du droit d'élaborer des politiques éthiques en matière d'IA qui préservent les valeurs sociétales.

Nous invitons les lecteurs à s'abonner à la lettre d'information de Deep Lex pour obtenir des mises à jour régulières sur l'éthique et la réglementation de l'IA, ainsi que des informations sur l'industrie. En restant informés et engagés, nous pouvons collectivement travailler à un avenir de l'IA qui équilibre l'innovation et la responsabilité, en veillant à ce que l'IA serve de force pour un changement positif.

Clause de non-responsabilité : Ce qui précède est fourni à titre d'information uniquement et ne constitue pas un avis juridique. Veuillez vous référer à la page des conditions générales pour plus d'informations.

Sources :

- Deep Lex, "L'impact de l'IA sur le droit et la société", 5 novembre 2024 ︎

- Loi européenne sur l'intelligence artificielle (règlement (UE) 2024/1689) ︎

- Loi de l'UE sur l'intelligence artificielle (règlement (UE) 2024/1689), voir par exemple (27) ︎

- National Institute of Justice, "Using Artificial Intelligence to Address Criminal Justice Needs", National Institute of Justice, 8 octobre 2018,(https://nij.ojp.gov/topics/articles/using-artificial-intelligence-address-criminal-justice-needs); Council on Criminal Justice, "The Implications of AI for Criminal Justice", Council on Criminal Justice, consulté le 5 mars 2024,(https://counciloncj.org/the-implications-of-ai-for-criminal-justice/). ︎

- Jeff Winter, "Tech Recruiting : How To Leverage AI In The Hiring Process", Forbes, 2 juin 2023,(https://www.forbes.com/councils/forbesbusinesscouncil/2023/06/02/tech-recruiting-how-to-leverage-ai-in-the-hiring-process/). ︎

- UNESCO. "Les États membres de l'UNESCO adoptent le premier accord mondial sur l'éthique de l'intelligence artificielle. UNESCO, 25 novembre 2021(https://www.unesco.org/en/articles/unesco-member-states-adopt-first-ever-global-agreement-ethics-artificial-intelligence). ︎

- OCDE, "L'état de la mise en œuvre des principes de l'OCDE en matière d'IA : Four Years On", Éditions OCDE, 7 novembre 2023(https://www.oecd.org/en/publications/the-state-of-implementation-of-the-oecd-ai-principles-four-years-on_835641c9-en.html). ︎

- Samek, W., Wiegand, T., & Müller, K. R. (2017) "Explainable Artificial Intelligence : Understanding, Visualizing, and Interpreting Deep Learning Models" Cornell University(https://arxiv.org/abs/1708.08296); "AI's Trust Problem", Harvard Business Review, 3 mai 2024(https://hbr.org/2024/05/ais-trust-problem). ︎

- Josh Howarth, "Number of parameters in GPT-4 (latest data)", Exploding Topics, 6 août 2024(https://explodingtopics.com/blog/gpt-parameters). ︎

- Bender, E. M., Gebru, T., McMillan-Major, A. et Shmitchell, S. (2021). "Sur les dangers des perroquets stochastiques : Can Language Models Be Too Big ?" In Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency (pp. 610-623), Association for Computing Machinery (ACM),(version disponible ici : https://dl.acm.org/doi/pdf/10.1145/3442188.3445922). ︎

- IEEE Xplore, "Peeking Inside the Black-Box : A Survey on Explainable Artificial Intelligence (XAI)", 2023(https://ieeexplore.ieee.org/document/8466590). ︎

- EEE Xplore, "Explainable Artificial Intelligence : A Review and Case Study on Model-Agnostic Methods," 2023,(https://ieeexplore.ieee.org/abstract/document/10373722). ︎

- Doshi-Velez, Finale, et Been Kim. "Vers une science rigoureuse de l'apprentissage automatique interprétable. Dernière modification le 27 février 2017,(https://arxiv.org/abs/1702.08608). ︎

- Lipton, Zachary C. "Le mythe de l'interprétabilité des modèles". Communications of the ACM 61, n° 10 (2018), p. 36-43(https://doi.org/10.1145/3233231). ︎

- Tiago P. Pagano et al, "Bias and Unfairness in Machine Learning Models : A Systematic Review on Datasets, Tools, Fairness Metrics, and Identification and Mitigation Methods" Big Data Cogn. Comput. 2023, 7(1), 15(https://doi.org/10.3390/bdcc7010015). ︎

- Comme ce fut le cas pour Amazon, Jeffrey Dastin, "Amazon Scraps Secret AI Recruiting Tool That Showed Bias Against Women", Reuters, 11 octobre 2018(https://www.reuters.com/article/world/insight-amazon-scraps-secret-ai-recruiting-tool-that-showed-bias-against-women-idUSKCN1MK0AG/). ︎

- Surveillance et police prédictive : Richardson, Rashida, Jason M. Schultz, et Kate Crawford. "Dirty Data, Bad Predictions : Comment les violations des droits civils ont un impact sur les données de la police, les systèmes de police prédictive et la justice." New York University Law Review 94 (2019), at 192-233 (version disponible ici : https://nyulawreview.org/online-features/dirty-data-bad-predictions-how-civil-rights-violations-impact-police-data-predictive-policing-systems-and-justice/). ︎

- Fuster, Andreas, Paul Goldsmith-Pinkham, Tarun Ramadorai et Ansgar Walther. "Predictably Unequal ? The Effects of Machine Learning on Credit Markets". The Journal of Finance 77, no. 1 (2022), 5-47(https://papers.ssrn.com/sol3/papers.cfm?abstract_id=3072038). ︎

- Yang, J., Soltan, A.A.S., Eyre, D.W. et al. "Algorithmic fairness and bias mitigation for clinical machine learning with deep reinforcement learning". Nat Mach Intell 5, 884-894 (2023)(https://www.nature.com/articles/s42256-023-00697-3). ︎

- Jeffrey Dastin, "Amazon Scraps Secret AI Recruiting Tool That Showed Bias Against Women", Reuters, 11 octobre 2018(https://www.reuters.com/article/world/insight-amazon-scraps-secret-ai-recruiting-tool-that-showed-bias-against-women-idUSKCN1MK0AG/). ︎

- Forum économique mondial. "Rapport sur les risques mondiaux 2024". Forum économique mondial, janvier 2024, p. 18-21(https://www.weforum.org/publications/global-risks-report-2024/). ︎

- Kuhlman, Charles, MaryAnne Smart, et Rayid Ghani. "Learning to Address Race, Gender, and Intersectional Biases in AI Systems (Apprendre à traiter les préjugés liés à la race, au genre et à l'intersectionnalité dans les systèmes d'IA) : A Human-Centered Approach." Nature Machine Intelligence 5, no. 6 (juin 2023) à 555-565 ; Pichai, Sundar. "AI at Google : Nos principes". Google (blog), 7 juin 2022(https://blog.google/technology/ai/ai-principles/); Loi de l'UE sur l'intelligence artificielle (règlement (UE) 2024/1689), voir par exemple (27). ︎

- Mehrabi, Ninareh, Fred Morstatter, Nripsuta Saxena, Kristina Lerman et Aram Galstyan. "A Survey on Bias and Fairness in Machine Learning" (Enquête sur les biais et l'équité dans l'apprentissage automatique). ACM Computing Surveys 54, no 6 (juillet 2021)(https://arxiv.org/abs/1908.09635); Jeffrey Dastin, "Amazon Scraps Secret AI Recruiting Tool That Showed Bias Against Women", Reuters, 11 octobre 2018(https://www.reuters.com/article/world/insight-amazon-scraps-secret-ai-recruiting-tool-that-showed-bias-against-women-idUSKCN1MK0AG/); IBM a également créé, AI Fairness 360 un outil open source pour "examiner, signaler et atténuer la discrimination et les préjugés dans les modèles d'apprentissage automatique tout au long du cycle de vie de l'application d'IA"(https://aif360.res.ibm.com/)︎.

- Feldstein, Steven. "The Global Expansion of AI Surveillance". Carnegie Endowment for International Peace, 17 septembre 2023(https://carnegieendowment.org/2019/09/17/global-expansion-of-ai-surveillance-pub-79847). ︎